بیش از 5 مورد

بیش از 21 مورد

بیش از 19 مورد

بیش از 13 مورد

بیش از 10 مورد

بیش از 8 مورد

بیش از 16 مورد

بیش از 9 مورد

بیش از 1 مورد

بیش از 15 مورد

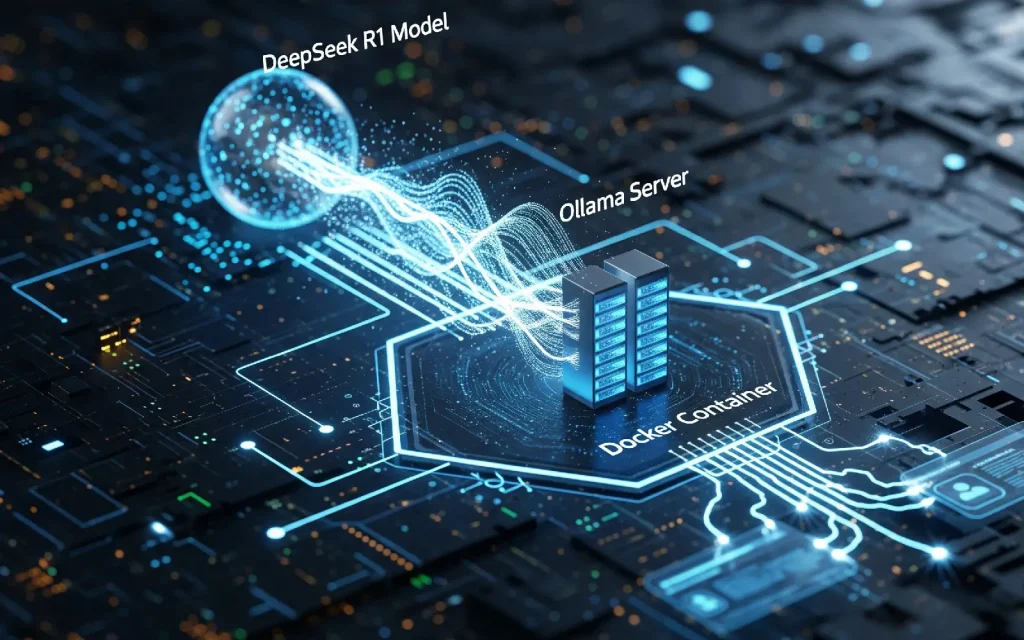

در دنیای امروز، مدلهای زبان بزرگ (LLM) نقش پررنگ و حیاتی در زمینههای مختلف هوش مصنوعی پیدا کردهاند. این مدلها نه تنها توانایی درک و تولید متنهای طبیعی را دارند، بلکه قادرند مسائل پیچیده ریاضی، برنامهنویسی، تحلیل داده و حتی تصمیمگیریهای منطقی را نیز پردازش کنند. در میان این مدلها، DeepSeek-R1 بهعنوان یکی از پیشرفتهترین و در عین حال بازترین مدلهای زبان شناخته میشود. این مدل با بهرهگیری از معماریهای نوین و آموزش روی حجم عظیمی از دادهها، توانایی استدلال پیشرفته و پردازش محاورهای طبیعی را ارائه میدهد و میتواند بهعنوان یک ابزار قدرتمند در پروژههای تحقیقاتی، توسعه نرمافزار، و کاربردهای تجاری مورد استفاده قرار گیرد.

اما یکی از بزرگترین چالشها برای بسیاری از افراد و شرکتها، اجرای مدلهای بزرگ بهصورت محلی و بدون وابستگی به سرویسهای ابری یا APIهای خارجی است. در اینجا Ollama وارد عمل میشود. Ollama یک پلتفرم قدرتمند و ساده برای مدیریت، اجرا و تعامل با مدلهای زبان بزرگ است که امکان بهرهگیری از DeepSeek و سایر مدلها را بهصورت محلی فراهم میکند. با استفاده از Ollama، کاربران میتوانند مدلهای خود را بدون نگرانی از محدودیتهای اینترنت یا هزینههای بالای سرویسهای ابری اجرا کرده و به راحتی آنها را در پروژههای خود ادغام کنند.

در این آموزش، ما بهطور جامع به شما نشان خواهیم داد که چگونه DeepSeek-R1 را با کمک Ollama راهاندازی و استفاده کنید. از نصب اولیه و بارگیری مدل گرفته تا اجرای دستورات و بهکارگیری آن در پروژههای واقعی، همه مراحل به زبان ساده و گامبهگام توضیح داده خواهد شد. همچنین، نکات مهمی برای بهینهسازی عملکرد مدل و انتخاب نسخه مناسب بر اساس نیازهای سختافزاری و نوع پروژه ارائه خواهد شد.

با یادگیری این مهارت، شما نه تنها قادر خواهید بود از یک مدل پیشرفته برای حل مسائل پیچیده استفاده کنید، بلکه میتوانید تجربهای عملی و کاربردی در زمینه اجرای مدلهای هوش مصنوعی بهصورت مستقل و محلی به دست آورید؛ چیزی که میتواند تفاوت بزرگی در توانمندیهای حرفهای شما ایجاد کند.

برای انجام این کار ollama را دانلود و نصب میکنیم. برای دانلود Ollama کلیک کنید.

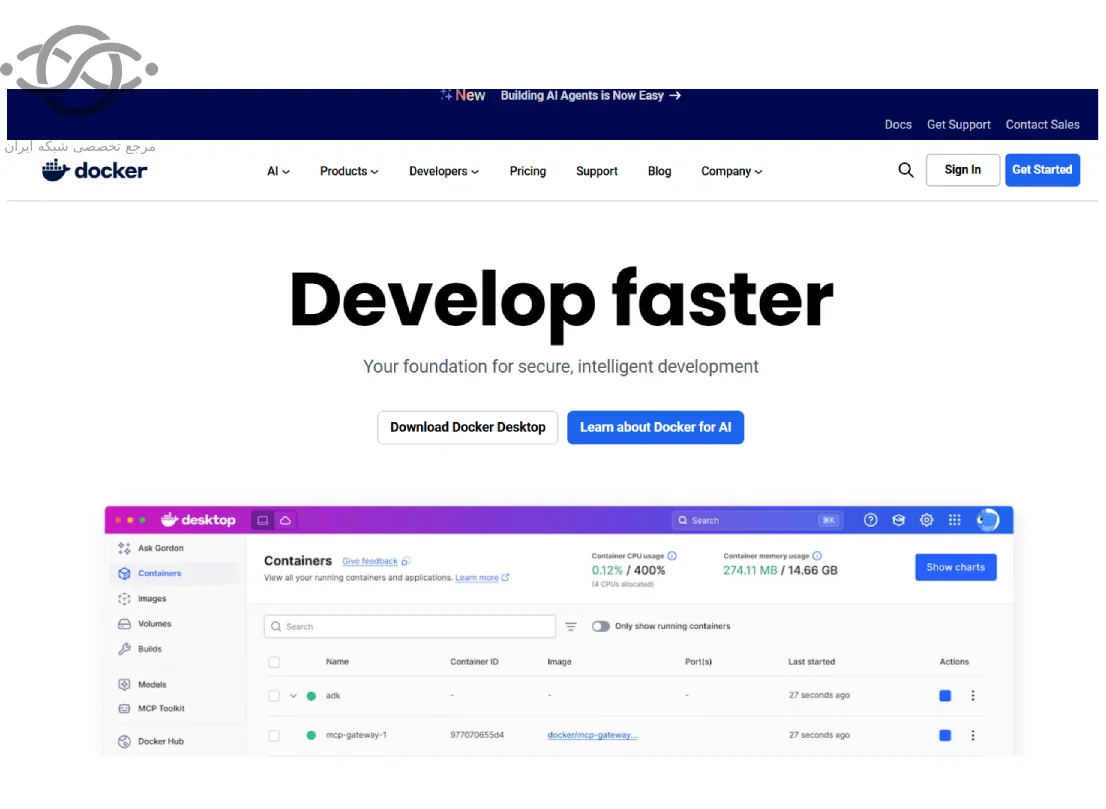

برای اینکه بتوانیم در محیطی با گرافیک بهتر از deepseek استفاده کنیم Docker Desktop را میبایست نصب کنیم که میتوانید از این لینک دانلود نمایید.

بعد از دانلود آن را نصب و سیستم را ری استارت نمایید.

بعد از بالا امدن سیستم، docker را بازنمایید ثبت نام کرده و وارد شوید.

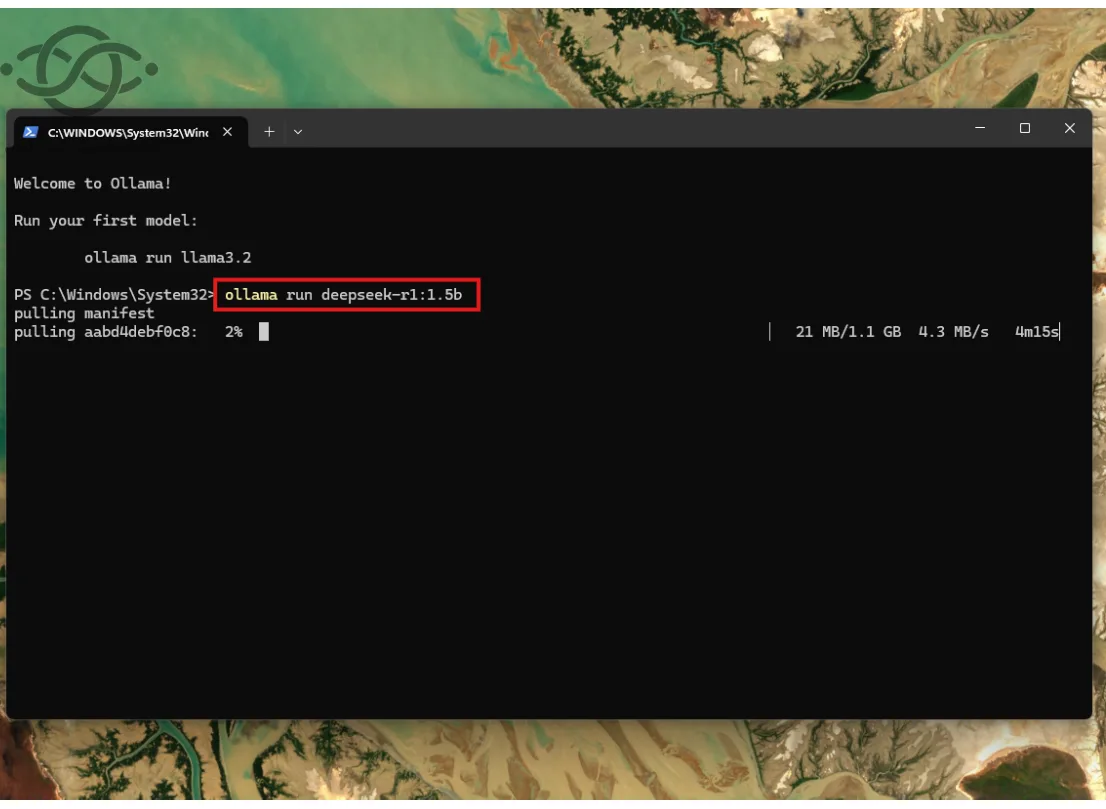

مدل مورد نظر از deepseek را انتخاب میکنیم با توجه به سخت افزاری که داریم. مدل های deepseek از 1.5B شروع شده و تا 70B ادامه دارد که از ضعیف ترین سخت افزار تا بالاترین و قوی ترین سخت افزار میتوانند پیشتیبانی کنند. اگر که به دنبال سرعت بالاتری هستید و رم و کارت گرافیکی قدرتمندی دارید میتوانید از مدل های بالاتر استفاده نمایید. با توجه به مدلی که انتخاب میکنید میتواند command مربوط به آن را کپی کرده، در سیستم خودتان command promp را باز کرده و آن را پیست نمایید.

ما مدل 1.5B را انتخاب کردیم که command آن به صورت زیر میباشد:

ollama run deepseek-r1:1.5b

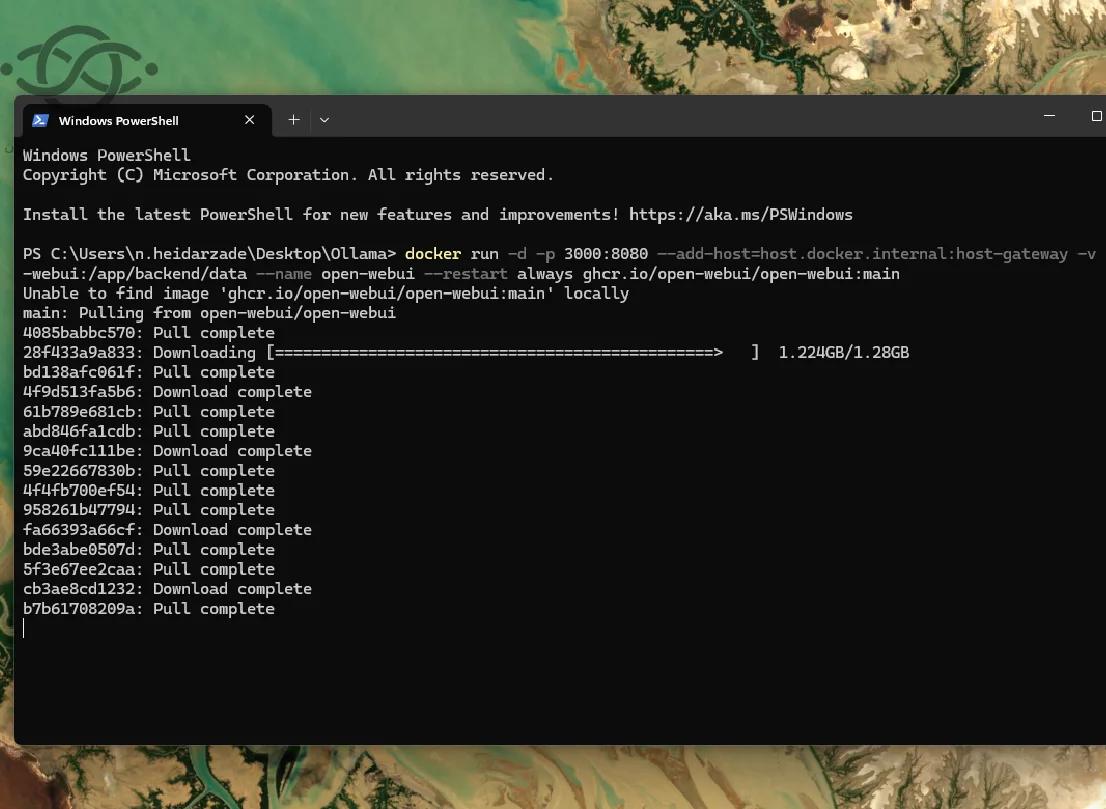

یک command promp جدید باز کرده سپس این command را که از این صفحه استخراج شده در آن اجرا کنید :

docker run -d -p 3000:8080 –add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data –name open-webui –restart always ghcr.io/open-webui/open-webui:main

در انتها پیغامی به شما ارسال میشه که allow را بزنید.

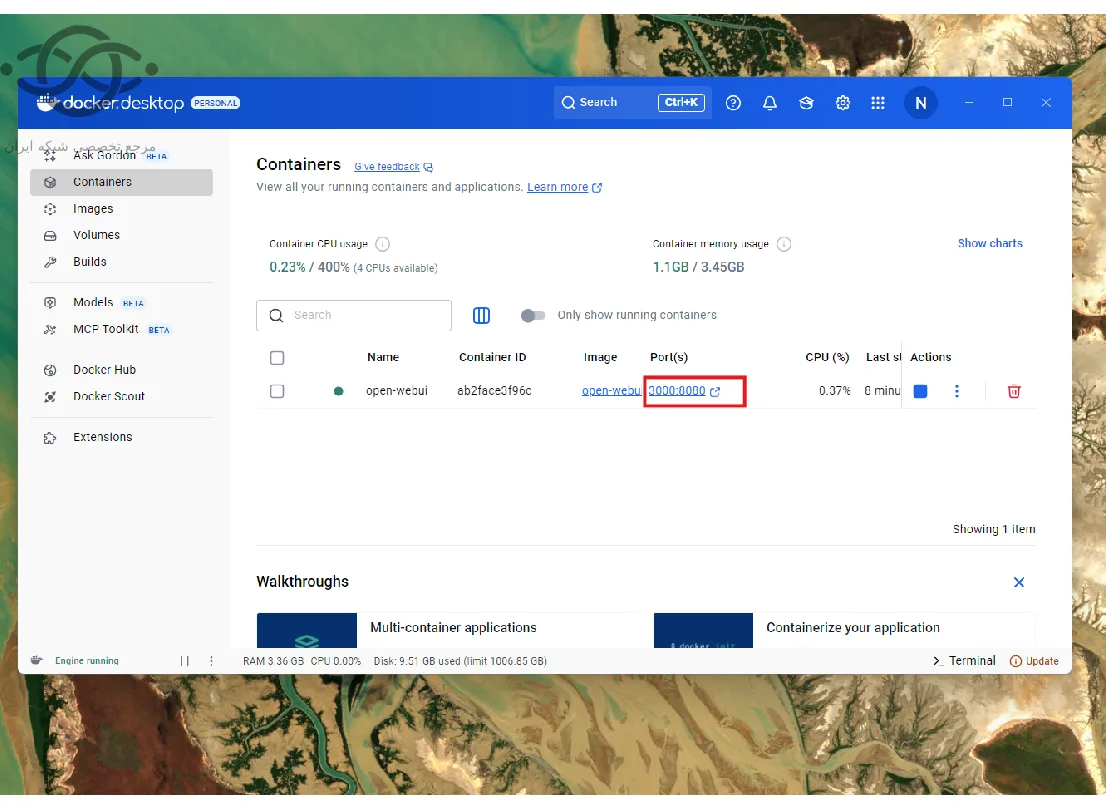

داخل docker روی این لینک بزنید و وارد شوید.

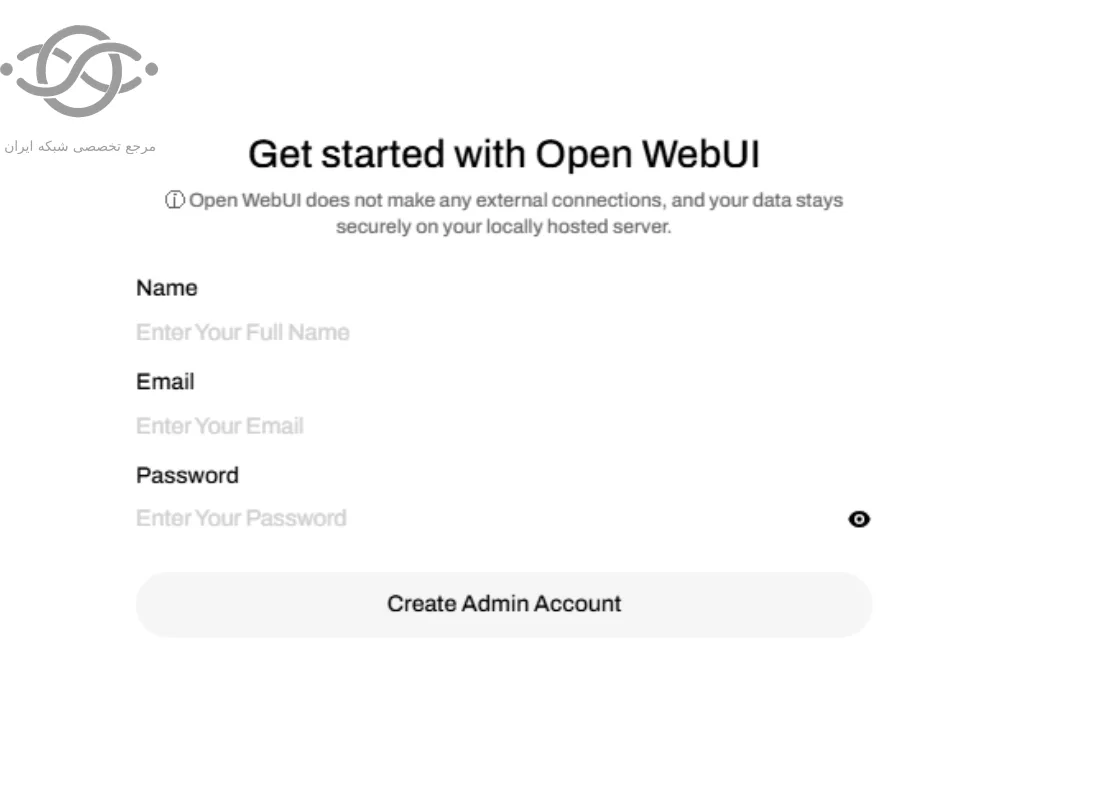

حالا شما میتوانید در UI مانند chatgpt از deepseek به صورت لوکال استفاده نمایید.

مرجع تخصصی شبکه ایران ؛ جایی که دانش، تجربه و منابع ارزشمند دنیای شبکه به زبان ساده و کاربردی در اختیار علاقهمندان، دانشجویان و متخصصان این حوزه قرار میگیرد.

طراحی شده توسط تیم فوژان

دیدگاهها

هیچ دیدگاهی برای این محصول نوشته نشده است.